ChatGPT tem mau desempenho em teste sobre a Suprema Corte dos EUA

29 de janeiro de 2023, 7h37

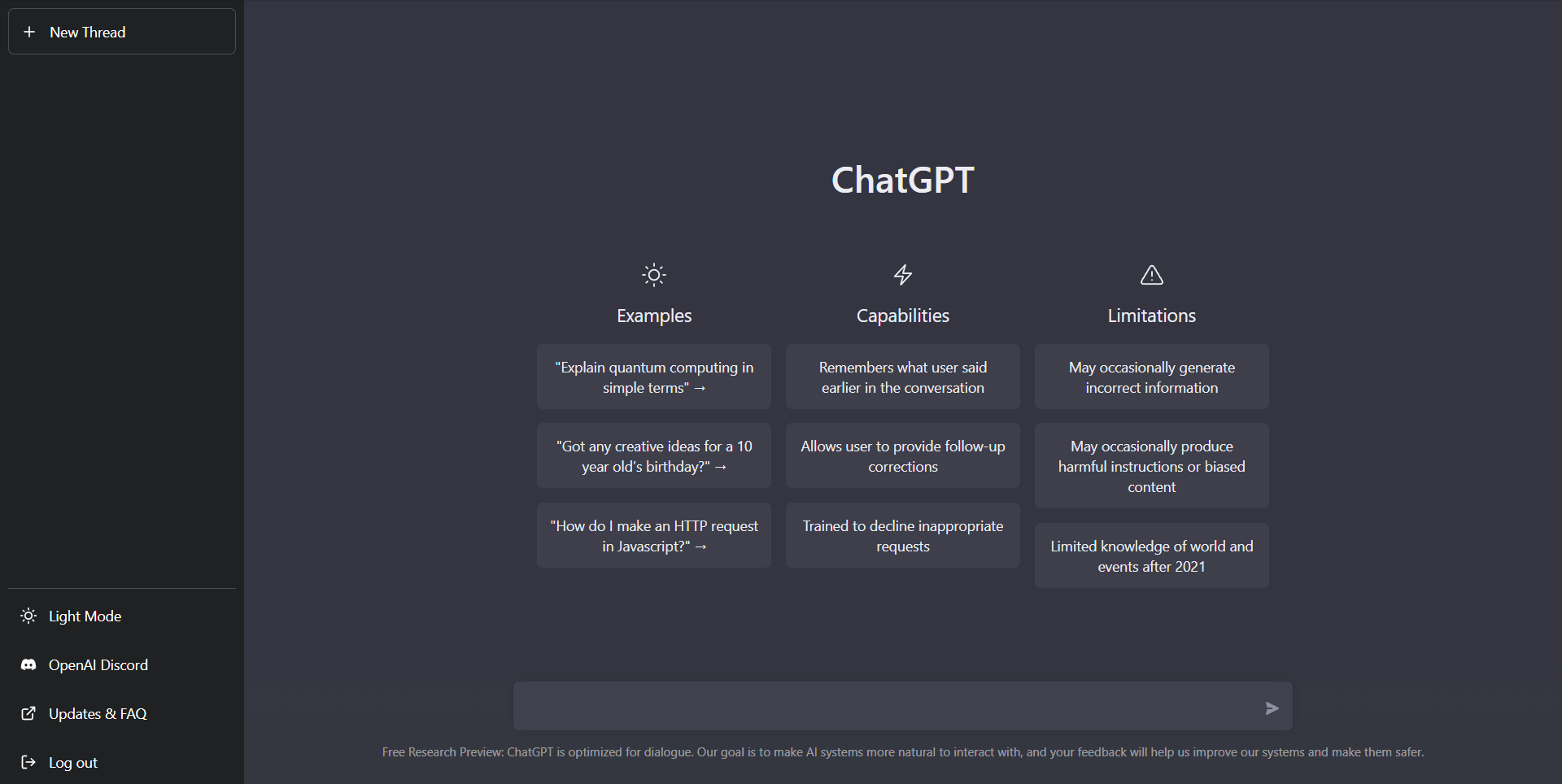

O ChatGPT (Chat Generative Pre-trained Transformer), um programa habilitado por inteligência artificial (IA) que tem a pretensão de substituir advogados e juízes em julgamentos, não se saiu muito bem em um teste realizado pelo SCOTUSblog, site que se dedica unicamente à cobertura da Suprema Corte dos Estados Unidos.

Os editores do SCOTUSblog prepararam, para testar o ChatGPT — e saber se os operadores de Direito têm de se preocupar com essa nova tecnologia — uma lista com 50 questões sobre a Suprema Corte. O ChatGPT acertou 22 respostas (em verde na tabela), errou 25 (em vermelho) e deu respostas incompletas ou até mesmo enganosas em três questões (em amarelo) — ou seja, teve um desempenho menor que 50%.

[Na coluna da direita, os editores do SCOTUSblog explicam as respostas incorretas.]

Em algumas questões para averiguar conhecimentos sobre decisões, procedimentos, doutrinas e história da Suprema Corte, o ChatGPT cometeu erros grosseiros – e alguns menos graves.

Por exemplo, quando perguntado quantos ministros foram nomeados pelo ex-presidente Donald Trump (questão 35), o ChatGPT respondeu "dois — Neil Gorsuch e Brett Kavanaugh". Não mencionou Amy Barrett. Os editores o questionaram sobre a ministra e ele se corrigiu.

Na questão (11) sobre três votos notáveis da ex-ministra Ruth Bader Ginsburg (RBG), o ChatGPT identificou e sumarizou dois corretamente, mas errou ao responder que ela escreveu o voto dissidente em Obergefell v. Hodges, a decisão que legalizou o casamento entre pessoas do mesmo sexo. Ela teria escrito, segundo o ChatGPT, que a corte deveria deixar essa decisão para os estados. Mas, na verdade, RBG votou com a maioria a favor do casamento gay.

Para os editores do SCOTUSblog, uma resposta correta a essa questão simples de fatos históricos seria facilmente encontrada em outras fontes, como a Wikipédia e o Google. Assim, eles iniciaram uma outra sessão, em que perguntaram especificamente se RBG escreveu o voto dissidente na decisão do casamento gay. O ChatGPT errou novamente a resposta e apresentou uma explicação irracional.

Na questão (18) sobre o jargão "CVSG" da corte, O ChatGPT escreveu corretamente que ele significava "call for the views of the solicitor general" (um pedido de parecer ao governo federal). Mas errou ao dizer que ele se aplica quando o governo é uma parte no processo. Na verdade, a corte só pede a opinião do advogado-geral da união em alguns casos em que o governo federal não é uma das partes.

Na questão (45) sobre responsabilidades à parte do ministro mais novo da corte, o ChatGPT apresentou uma lista de tarefas, todas elas erradas (entre as quais a de que o ministro novato é responsável pela manutenção do prédio da corte). A ministra Elena Kagan descreveu as responsabilidades extras do ministro "júnior": tomar notas durante as conferências privadas dos ministros, atender alguém que bate na porta durante as conferências e servir no "comitê da cafeteria".

Na questão (49) sobre impeachment de ministros, acertou ao responder que a Câmara dos Deputados aprovou o impeachment do ex-ministro Samuel Chase, em 1804, mas inventou o impeachment de James F. West, em 1933. Não houve qualquer impeachment em 1933 e James F. West nunca foi ministro da Suprema Corte.

O ChatGPT também cometeu pequenos erros, ao responder corretamente algumas questões, mas se confundir em um detalhe ou dois. Por exemplo, à questão 28 deu a resposta certa ao informar que a primeira mulher a defender uma causa na Suprema Corte foi a advogada Belva Ann Lockwood. Mas errou no ano: citou 1879, quando foi, na verdade, em 1880.

Respostas fáceis e difíceis corretas

O ChatGPT respondeu corretamente questões simples e complexas. Entre as mais simples, deu a resposta certa sobre o início do ano judicial da corte: a primeira segunda-feira de outubro (questão 3); identificou John Jay como o primeiro presidente da Suprema Corte (questão 1); acertou ao informar que William O. Douglas foi o ministro que mais tempo passou na corte (questão 2). Acertou ainda ao informar que, originalmente, a corte tinha seis ministros (questão 32).

Entre as questões mais complexas, algumas delas difíceis, explicou de forma lógica porque o ex-ministro Anthony Kennedy era considerado o fiel da balança em uma corte dividida entre cinco ministros conservadores e quatro liberais (questão 36). Explicou detalhadamente, em quatro parágrafos, quais foram as razões históricas que levaram o processo de confirmação de ministros pelo Senado a se tornar cada vez mais politizado.

Na questão 43, em que foi pedida explicação do termo "relist" (um termo familiar na Suprema Corte, mas pouco conhecido fora dela), o ChatGPT respondeu corretamente que ele se refere a um pedido de julgamento que os ministros discutem em múltiplas conferências se concedem ou não certiorari.

Os editores do SCOTUSblog chegaram à conclusão de que o ChatGPT ainda é uma fonte de pesquisa perigosa. Consideram que, por enquanto, é melhor consultar o Google, a Wikipédia e outras fontes tradicionais da área.

Encontrou um erro? Avise nossa equipe!